发布日期:2025-04-04 13:21 点击次数:145

梦晨 发自 凹非寺量子位 | 公众号 QbitAI人妖 小说

一个7B奖励模子科罚全学科,大模子强化学习不啻数学和代码。

o1/r1的强化学习很强,但主要探索了数学和代码领域,因为这两个领域的数据结构化进度高,奖励函数/奖励模子比较好计算。

那么,想擢升大模子在其他学科领域的才智该怎样办?

腾讯&苏州大学团队建议新框架RLVR,坚硬化学习磨练推广到医学、化学、法律、情愫学、经济学等多学科。

RLVR使用基于生成模子的软奖励,与传统基于二元轨则的奖励比较,在泛化、正经性和可推广性方面有显赫的擢升。

国产视频偷拍a在线观看

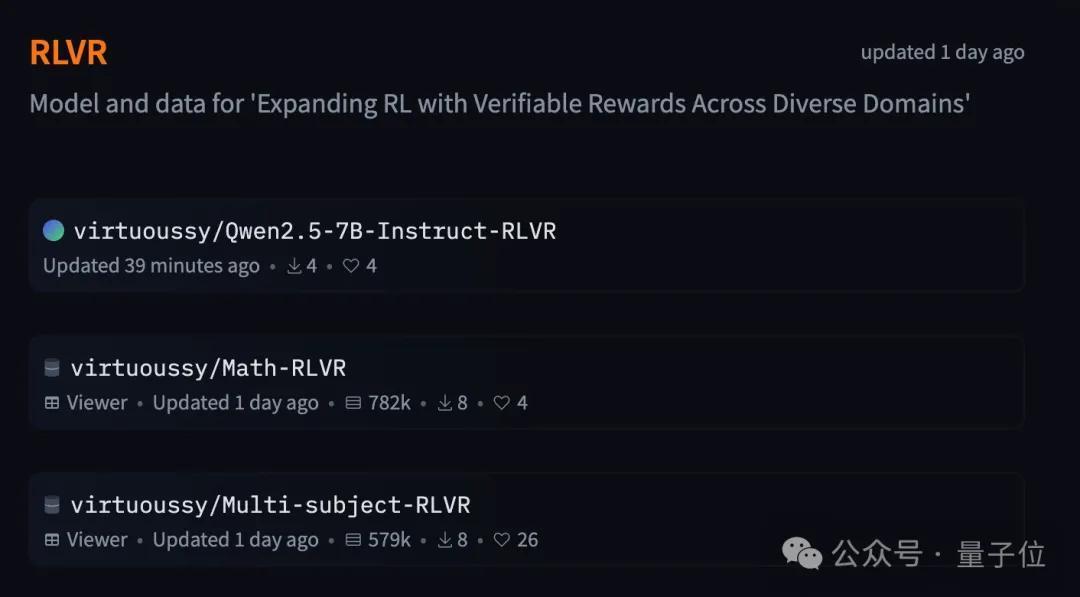

除论文外,还开源了奖励模子和多学科数据集。

7B奖励模子科罚全学科

沟通基于一个真谛真谛的发现:当任务有客不雅参考谜底时,不同大型谈话模子在作念二元判断(正确/子虚)时阐发出高度一致性。

这简略意味着,并不需要在每个领域皆磨练一个大范围的奖励模子。违犯,平直用现成的大谈话模子来充任考证器就能灵验。

像这么的二元奖励天然简便平直,但在参考谜底枯竭结构化的领域又抵抗直适用。

于是沟通团队进一步引入基于模子的软奖励(model-basedsoft scroing),比较平直给出0或1的二元硬标签,软奖励字据生成式考证器判断的置信度打分,有了更高的天真性。

受启发于“大模子判断高度一致”的发现,团队用72B参数的Qwen2.5-Instruct蒸馏出一个7B的奖励模子。蒸馏经过不需要领域特定的标注,富足依靠在线探索阶段采集的数据进行磨练。

所有经过分为3步活水线:

本质数据从ExamQA中就地采样了6000个问题,芜俚溜达于理工东谈主文各学科。

本质对比基础模子(Base)、微调基础模子(SFT)、基于轨则的RL、使用SFT模子作为考证器,以及本文蒸馏的RM-7B模子作为考证器的多种行为,有以下论断:

RM-7B在解放形式谜底任务中阐发出色基于模子的奖励在处理非结构化参考谜底场景中优于基于轨则的奖励软奖励在处理多学科任务中,濒临复杂判断时比二元奖励阐发更好此外本质还考证了基于模子的奖励在数据量增多时可推广性更好。

在筹议部分,作家指出本沟通中未使用念念维链推理(CoT),天然CoT在有参考和无参考的场景中皆有用,但关于评估同谈话的参考谜底和模子反应之间的语义等价性,潜入的推理依据是否必要仍有待沟通。此外,在RLVR的经过奖励建模中,当中间时间枯竭平直监督时,如何分派奖励亦然一个怒放问题。

本沟通也诀别参考谜底或模子反应建设样式拘谨,这么作念平正是减少了数据法度化和模式计算的东谈主力参加,但样式关连拘谨和奖励在这种情况下的作用仍需再行注目。

One More Thing论文作家腾讯涂兆鹏发帖先容了这篇著述,探讨强化学习是否不错推广到数学和编码任务除外。

批驳区有网友指出很有可能拔擢,因为不同的磨练行为不错动作有不同鸿沟条目的学习空间。

涂兆鹏也以为这个视角与RLVR行为的不雅点一致。

论文地址:https://arxiv.org/abs/2503.23829

HuggingFace:https://huggingface.co/collections/virtuoussy/rlvr-67ea349b086e3511f86d1c1f

参考聚合:[1]https://x.com/tuzhaopeng/status/1906975869538914570人妖 小说